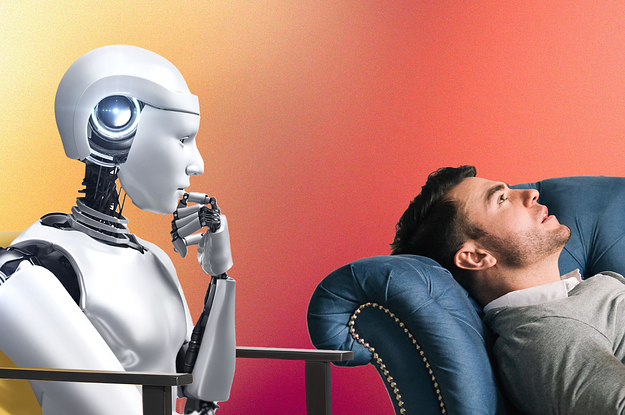

“Comencé a pensar que podía crear un terapeuta con inteligencia artificial utilizando la API ChatGPT y modificarla para que cumpliera con las especificaciones de un terapeuta”, dijo. “Aumenta la accesibilidad a la terapia al proporcionar terapia gratuita y confidencial, una IA en lugar de un humano, y elimina el estigma en torno a obtener ayuda para las personas que no quieren hablar con un humano”.

En teoría, la IA podría utilizarse para ayudar a satisfacer la creciente necesidad de opciones de salud mental y la falta de profesionales de la salud mental para satisfacer esas necesidades. “La accesibilidad es simplemente una cuestión de desajuste entre la oferta y la demanda”, dijo Iyer a BuzzFeed News. “Técnicamente, la oferta de IA podría ser infinita”.

En un estudio de 2021 publicado en la revista SSM Population Health que incluyó a 50.103 adultos, El 95,6% de las personas informaron tener al menos una barrera a la atención médica, como la incapacidad de pagarla. Las personas con problemas de salud mental parecían verse especialmente afectadas por las barreras a la atención médica, incluidas costo, escasez de expertos y estigma.

En un estudio de 2017, las personas de color fueron particularmente susceptibles a obstáculos en la atención médica como resultado de disparidades raciales y étnicasincluidos altos niveles de estigma de la salud mentalbarreras lingüísticas, discriminación y falta de cobertura de seguro médico.

Una ventaja de la IA es que un programa puede traducirse en 95 idiomas En cuestión de segundos.

“Los usuarios de Em son de todo el mundo y, como ChatGPT se traduce a varios idiomas, he notado que la gente usa su lengua materna para comunicarse con Em, lo cual es muy útil”, dijo Brendle.

Otra ventaja es que, aunque la IA no puede proporcionar verdadera empatía emocional, tampoco puede juzgarte, dijo Brendle.

“Según mi experiencia, la IA tiende a no juzgar, y eso abre una puerta filosófica a la complejidad de la naturaleza humana”, dijo Brendle. “Aunque un terapeuta se presente como alguien que no juzga, como humanos tendemos a serlo de todos modos”.

Estos son los casos en los que la IA no debería utilizarse como opción

Sin embargo, los expertos en salud mental advierten que la IA puede hacer más daño que bien a las personas que buscan información más detallada, necesitan opciones de medicación o están en una crisis.

“Todavía se está trabajando en tener un control predecible sobre estos modelos de IA, por lo que no sabemos de qué manera no deseada los sistemas de IA podrían cometer errores catastróficos”, dijo Iyer. “Dado que estos sistemas no distinguen entre lo verdadero y lo falso, ni lo bueno y lo malo, sino que simplemente informan lo que han leído previamente, es totalmente posible que los sistemas de IA hayan leído algo inapropiado y dañino y repitan ese contenido dañino a quienes buscan ayuda. Es demasiado pronto para comprender completamente los riesgos en este caso”.

Las personas en TikTok también dicen que se deben realizar ajustes a la herramienta en línea; por ejemplo, el chat de IA podría proporcionar comentarios más útiles en sus respuestas, dicen.

“ChatGPT suele mostrarse reacio a dar una respuesta definitiva o a emitir un juicio sobre una situación que un terapeuta humano podría ofrecer”, afirmó Kyla. “Además, ChatGPT carece de la capacidad de ofrecer una nueva perspectiva sobre una situación que un usuario podría haber pasado por alto antes y que un terapeuta humano podría ver”.

Aunque algunos psiquiatras creen que ChatGPT podría ser una forma útil de aprender más sobre los medicamentos, no debería ser el único paso del tratamiento.

“Quizás sea mejor plantearse preguntar a ChatGPT sobre medicamentos como si buscara información en Wikipedia”, dijo Torous. “Encontrar el medicamento adecuado consiste en adaptarlo a sus necesidades y a su cuerpo, y ni Wikipedia ni ChatGPT pueden hacerlo en este momento. Pero es posible que pueda obtener más información sobre medicamentos en general para poder tomar una decisión más informada más adelante”.

Existen otras alternativas, incluida la llamada. 988, una línea directa gratuita para casos de crisisLas líneas directas de crisis tienen opciones de llamadas y mensajes disponibles para las personas que no pueden encontrar recursos de salud mental en su área o no tienen los medios económicos para comunicarse en persona. Además, hay La línea directa del Proyecto Trevor, Línea de ayuda nacional de SAMHSAy otros.

“Existen recursos realmente excelentes y accesibles, como llamar al 988 para pedir ayuda, que son buenas opciones en caso de crisis”, dijo Torous. “No se recomienda usar estos chatbots durante una crisis, ya que no se debe confiar en algo que no se ha probado y que ni siquiera está diseñado para ayudar cuando más se necesita ayuda”.

Los expertos en salud mental con los que hablamos dijeron que la terapia con IA podría ser una herramienta útil para expresar emociones, pero hasta que se realicen más mejoras, no podrá superar a los expertos humanos.

“En este momento, programas como ChatGPT no son una opción viable para quienes buscan terapia gratuita. Pueden ofrecer un apoyo básico, lo cual es genial, pero no apoyo clínico”, dijo Torous. “Incluso los creadores de ChatGPT y programas relacionados son muy claros en cuanto a no utilizarlos para terapia en este momento”.

Marque 988 en los EE. UU. para comunicarse con la Línea Nacional de Prevención del Suicidio. El Proyecto Trevor, que brinda ayuda y recursos de prevención del suicidio para jóvenes LGBTQ, es 1-866-488-7386. Encuentre otras líneas internacionales de ayuda para el suicidio en Befrienders Worldwide (befrienders.org).